Relu

Relu(Linear rectification function)是深度学习中的一种激活函数

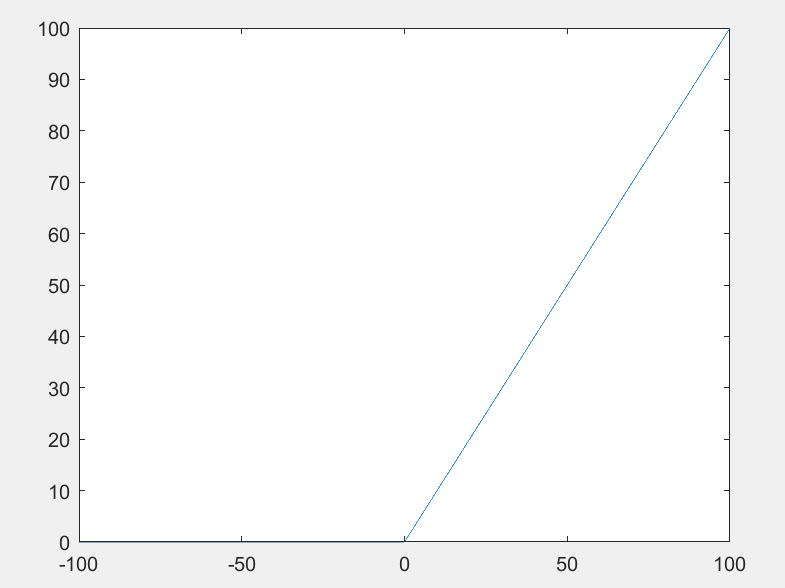

其函数表达式为:f(x)=max(0,x)

其函数图像为:

该函数主要用于cnn卷积神经网络的卷积(Convolution)和池化(MaxPooling)中,因为经过卷积运算和池化运算后的图像矩阵的值有正有负,这难免造成了数据规模变得很大,那么经过Relu函数之后的图像矩阵中的值只留下正数的值。

优点:

1.极大地减少了数据量#

2.在一定程度上减少了运算量#

3.避免层数增加。

0.0分

1 人评分

C语言网提供由在职研发工程师或ACM蓝桥杯竞赛优秀选手录制的视频教程,并配有习题和答疑,点击了解:

一点编程也不会写的:零基础C语言学练课程

解决困扰你多年的C语言疑难杂症特性的C语言进阶课程

从零到写出一个爬虫的Python编程课程

只会语法写不出代码?手把手带你写100个编程真题的编程百练课程

信息学奥赛或C++选手的 必学C++课程

蓝桥杯ACM、信息学奥赛的必学课程:算法竞赛课入门课程

手把手讲解近五年真题的蓝桥杯辅导课程

发表评论 取消回复