哪位大师来看看哪有问题 摘要:#include<iostream> using namespace std; int a[100000][100000]; int print(int l,int r,int w,int s)…… 文章列表 2022年07月12日 0 点赞 2 评论 297 浏览 评分:9.9

自由落体的运算 摘要:想像出它的轨迹,经过的长度可以是上升再落下,往复,即每次下落的距离*2相加,用for循环即可,再减去它刚开始没有上升的距离就行;#include<stdio.h>#include<math.h>int…… 文章列表 2022年07月12日 0 点赞 0 评论 360 浏览 评分:9.9

我们为什么要学编程?——来自一名学生的真实感受 摘要:如果有人问你:“我们为什么要学编程?”,你会怎么回答?大部分家长及编程学员肯定会说:“打比赛啊,拿奖状择校啊!”我认为:对,但也不全对。本次我们就先抛开繁琐的编程题,想一想我们学编程的初衷。1.编程到…… 文章列表 2022年07月15日 0 点赞 1 评论 525 浏览 评分:9.9

随机出题机 摘要:空闲时间随兴写的程序import random as r neirong=input('请输入您需要练习的内容(加/减/乘/除):') tishu=eval(input('…… 文章列表 2022年07月16日 0 点赞 0 评论 366 浏览 评分:9.9

英语激励名言 (•̀ω•́)✧ 摘要:Six sentences of English motivational quotes六句英语激励名言(•̀ω•́)✧① All of his wise men, all of them fools…… 文章列表 2022年07月20日 0 点赞 1 评论 308 浏览 评分:9.9

求一个很大的数的所有质因子(新方法) 摘要:今天做到这个题https://www.dotcpp.com/oj/problem2692.html 才知道原来求质因子还有怎么巧妙的方法。 我一直用的方法: ```python n=int(in…… 文章列表 2022年07月21日 0 点赞 0 评论 533 浏览 评分:9.9

每日语录 2022/7/22 摘要:繁星冰心繁星(二)童年呵!是梦中的真, 是真中的梦, 是回忆时含泪的微笑。繁星(五)黑暗,怎样的描画呢?心灵的深深处, 宇宙的深深处, 灿烂光中的休息处。…… 文章列表 2022年07月22日 0 点赞 1 评论 265 浏览 评分:9.9

精品文章 tarjan解决LCA问题 摘要:## 详解使用 Tarjan 求 LCA 问题(图解) LCA问题有多种求法,例如倍增,Tarjan。 本篇博文讲解如何使用Tarjan求LCA。 如果你还不知道什么是LCA,没关系…… 文章列表 2022年07月22日 0 点赞 2 评论 380 浏览 评分:9.9

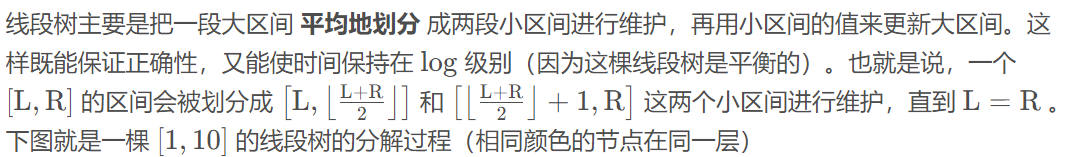

精品文章 线段树多种变形 摘要:## 线段树的题目多种变形 #### 线段树主要用于解决区间查询问题  …… 文章列表 2022年07月23日 0 点赞 0 评论 514 浏览 评分:9.9

精品文章 python的numpy模块使用简单教程 摘要:# Numpy 介绍 NumPy(Numerical Python) 是 Python 语言的一个扩展程序库,支持大量的维度数组与矩阵运算,此外也针对数组运算提供大量的数学函数…… 文章列表 2022年07月24日 0 点赞 0 评论 600 浏览 评分:9.9